Chain-of-Thought: логика через пошаговые объяснения

214

214

Chain-of-Thought (CoT) — техника prompt-инжиниринга, при которой модель не просто выдает ответ, а показывает промежуточные шаги рассуждения. Это повышает точность на сложных задачах и делает выводы прозрачными и проверяемыми.

Почему Chain-of-Thought работает и зачем его использовать

Когда модель получает задачу и сразу выдаёт ответ, мы видим только результат — без контекста того, как он получен. CoT меняет это: модель «думает вслух», разбивая задачу на этапы. Такой подход полезен по нескольким причинам:

- он упрощает валидацию: можно проверять каждый шаг и находить ошибку до финального ответа;

- он помогает в задачах с многопроходным рассуждением (арифметика, логика, планирование, юридический разбор);

- он даёт обучающий эффект — человек видит методику решения и может её переиспользовать;

- в прикладных системах промежуточные величины можно использовать дальше (логика ветвлений, принятие решений).

Однако CoT не всегда нужен. Для простых вычислений или когда важна только краткость, добавление детальных рассуждений увеличит время и токены без пользы. Кроме того, качество CoT сильно зависит от модели: крупные LLM обычно дают более корректные и содержательные шаги, а мелкие — могут путаться и генерировать неверные промежуточные выводы.

Где Chain-of-Thought особенно полезен

CoT наиболее естественно применим в задачах, где требуется последовательное мышление: математика и арифметика, сложная логика и дедукция, разбор юридических кейсов, генерация и отладка кода (показывать промежуточные вычисления или предположения), анализ данных и интерпретация таблиц, планирование и составление пошаговых инструкций, образовательные задачи и экзаменационные разборы. Для каждого из этих сценариев важно контролировать формат вывода и проверять ключевые промежуточные значения.

Как применять CoT на практике

1) Выбор стиля: zero-shot vs few-shot

Zero-shot CoT — это когда вы даёте одну инструкцию типа «Давай рассуждать шаг за шагом» или «Объясни каждый шаг решения». Это просто и быстро. Few-shot CoT — когда вы даёте несколько примеров задач с полными пошаговыми решениями: модель подхватывает стиль и чаще воспроизводит качественные рассуждения.

Пример zero-shot (короткий промпт):

Реши задачу и объясни каждый шаг: <текст задачи>. Давай рассуждать шаг за шагом.

Пример few-shot (формат):

Пример 1:

Вопрос: У Пети 12 конфет, отдал 1/3 друзьям. Сколько осталось?

Решение:

1) 1/3 от 12 = 4

2) 12 − 4 = 8

Ответ: 8

Пример 2:

Вопрос: <еще пример>

Решение:

1) ...

Ответ: ...

Теперь реши задачу: <реальная задача>. Пиши решение пошагово, не пропускай вычислений.

2) Форматирование вывода и строгие требования

Чтобы модель давала удобный результат для автоматической обработки, явно указывайте формат: «в конце выведи строку в формате Итог: <число>» или «шаги нумеруй, используй только цифры, не округляй до финала». Форматирование снижает неоднозначность и облегчает парсинг.

3) Контроль качества: проверяйте и сравнивайте

Всегда проверяйте промежуточные шаги. Для критичных задач используйте «self-consistency» — генерируйте несколько цепочек рассуждений (через разные семплы/seed) и берите наиболее частый итог. Это помогает снизить риск ошибки, особенно у шумных моделей.

Конкретные примеры

Ниже — два варианта решения одной и той же задачи: без CoT (коротко) и с CoT (пошагово).

Условие (исходные данные):

- 3 товара по 1200.

- Скидка 15% применяется только к товарам.

- Промокод −200 применяется после скидки, но до доставки.

- Доставка 350 (без НДС).

- НДС 20% начисляется только на товары после скидки и промокода; доставку не облагай.

Вариант без CoT — ответ одним числом (без объяснений)

3782

Вариант с CoT — просим пошаговое рассуждение и строгий финал

Промпт (пример):

Решай по шагам и показывай промежуточные суммы. Не округляй до финала.

В конце выведи строку строго в формате: Итог: <число>

Исходные данные:

— 3 товара по 1200

— Скидка 15% на товары

— Промокод −200 после скидки

— Доставка 350 без НДС

— НДС 20% только на товары

Ожидаемый ответ (пример вывода модели):

- Сумма товаров: 3 × 1200 = 3600

- Сумма скидки: 15% от 3600 = 540

- После скидки: 3600 − 540 = 3060

- Применяем промокод: 3060 − 200 = 2860 (это база для НДС)

- НДС 20%: 2860 × 0.20 = 572

- Доставка: 350 (без НДС)

- Итого: 2860 + 572 + 350 = 3782

Строка финала (строго):

Итог: 3782

(Примечание: поддержка детальных рассуждений зависит от модели; на некоторых моделях нужно давать больше примеров или формализовать требования.)

Советы, лучшие практики и ошибки, которых стоит избегать

CoT хорош там, где нужен прозрачный ход мыслей, но он дороже по ресурсам (больше токенов) и может увеличить вероятность «логических» галлюцинаций в маленьких моделях. Чтобы снизить риск ошибок, формализуйте требования к шагам, приводите примеры в few-shot формате, проверяйте ключевые промежуточные значения и используйте self-consistency. Не просите модель «думать вслух», если это создаёт риск раскрытия конфиденциальной информации (в объяснениях модель может ненароком восстановить детали из контекста).

Для автоматизации и масштабирования рассмотрите Auto-CoT — подходы, где демонстрации генерируются автоматически и затем используются в few-shot, — и комбинируйте CoT с внешними инструментами (калькуляторы, проверяющие скрипты, базы знаний).

Расширенные техники (если нужно масштабировать)

Если ваша задача требует систематической генерации CoT-решений для большого числа запросов, используйте:

- Auto-CoT: автоматически генерируйте демонстрационные примеры при помощи модели, чтобы снизить ручную работу.

- Self-consistency: генерируйте N цепочек рассуждений и выбирайте наиболее частый итог.

- RAG + CoT: сначала извлекайте релевантные факты из внешней базы (retrieval), затем просите модель рассуждать по шагам с учётом найденного контента — это снижает вероятность выдумывания фактов.

- Наблюдение и логирование: сохраняйте промежуточные шаги для аудита и отладки.

Chain-of-Thought — это практичный инструмент для повышения качества ответов LLM на задачи с многопроходным рассуждением и для повышения прозрачности выводов. Он особенно полезен в математике, логике, юридическом анализе, кодогенерации и обучении. Применяйте CoT там, где важна проверяемость и объяснимость, формализуйте формат вывода и проверяйте промежуточные значения. Для критичных сценариев комбинируйте CoT с методами контроля качества (self-consistency, внешние проверки) и подбирайте подходящую модель по мощности.

Авторизуйтесь, чтобы оставить комментарий.

Нет комментариев.

Тут может быть ваша реклама

Пишите info@aisferaic.ru

Похожие статьи

Рассуждение (Reasoning) в больших языковых моделях (LLM): теория и практика

0,0

0,0

176

176

Self-Consistency – Самосогласованность: как повысить точность ответов LLM

0,0

0,0

220

220

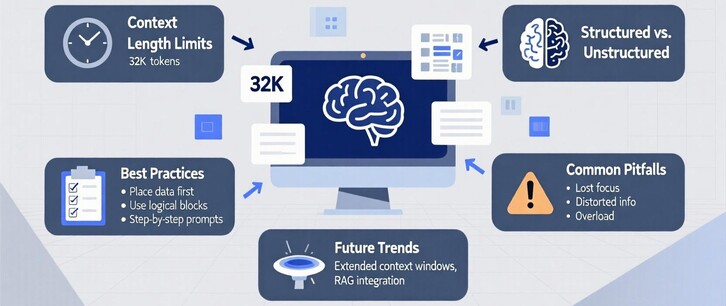

Работа с контекстом в длинных промптах: теория, практика и рекомендации

5,0

5,0

192

192